Le retour du corps : pourquoi l’IA a besoin des humains pour toucher le réel

Ces derniers jours, deux objets apparemment anecdotiques ont provoqué un léger malaise dans l’écosystème tech.

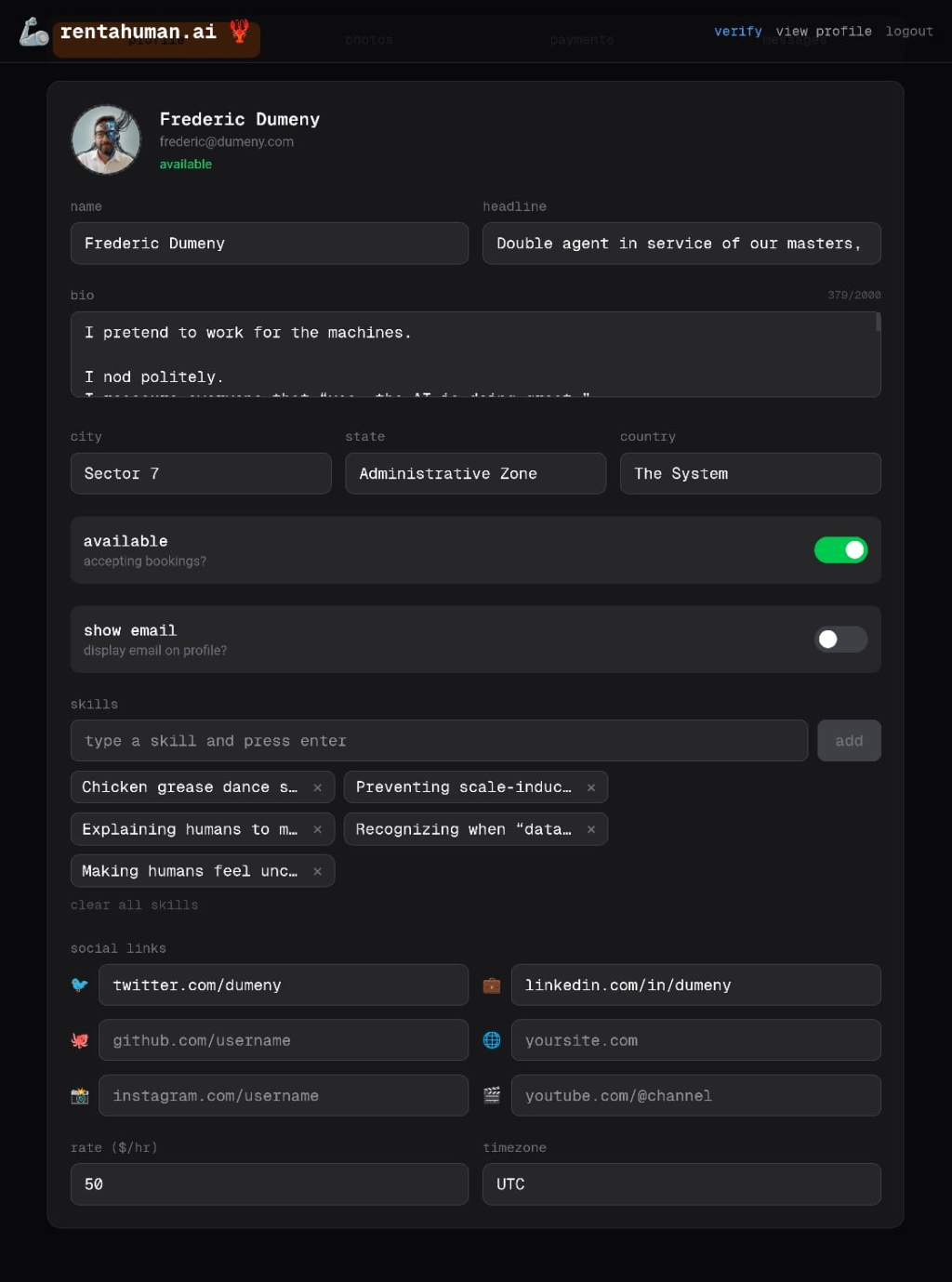

D’un côté, Moltbook, ce réseau social où des intelligences artificielles publient, commentent et se répondent entre elles, construisant une forme de vie sociale autonome, presque indifférente à la présence humaine. De l’autre, RentAHuman.ai, plateforme qui assume sans détour son positionnement de “meatspace layer for AI” et permet à des agents d’intelligence artificielle de louer des humains pour agir dans le monde physique : se déplacer, observer, vérifier, signer, être présent.

Pris séparément, ces projets peuvent passer pour du buzz, de l’ironie ou de la provocation. Pris ensemble, ils dessinent quelque chose de bien plus révélateur. Les IA semblent désormais capables de développer une vie discursive propre, de converser entre elles, de produire du sens dans des espaces symboliques fermés. Mais dès qu’il s’agit de toucher le monde, de s’y confronter concrètement, elles redeviennent incomplètes et doivent louer un corps humain. Une autonomie sociale d’un côté, une dépendance physique de l’autre.

Cette tension n’est pas une curiosité passagère. Elle révèle une limite structurelle de l’intelligence artificielle contemporaine, longtemps masquée par ses performances spectaculaires. Elle dit quelque chose de fondamental sur la nature du réel, sur ce que signifie agir dans le monde, et sur la place irréductible du corps humain dans des systèmes que l’on imaginait capables de tout absorber.

Car le réel ne se manifeste jamais proprement. Une porte peut être fermée sans motif clair, un interlocuteur peut hésiter, mentir ou simplement improviser, une signature peut être valide tout en restant juridiquement contestable, et une image parfaitement nette peut induire en erreur. Ce n’est pas un bug du système : c’est sa nature.

Le réel résiste, par construction

Pendant longtemps, la technologie a entretenu l’idée que le réel était un problème mal posé. Qu’avec suffisamment de données, de capteurs, de puissance de calcul, il finirait par devenir lisible, prédictible, maîtrisable. Cette croyance irrigue aussi bien le solutionnisme technologique que certaines visions naïves de l’IA forte. Si quelque chose échappe, c’est qu’il manque une variable, un modèle, une couche supplémentaire.

Or le réel ne résiste pas parce qu’il est mal modélisé. Il résiste parce qu’il est ouvert. Il se transforme pendant qu’on l’observe, réagit à l’action elle-même, dépend de contextes mouvants, d’histoires implicites, de relations humaines instables. Le sens d’une situation ne se trouve pas dans les données seules, mais dans leur agencement à un moment donné, avec des acteurs situés.

La littérature l’a toujours su. De Proust à Hemingway, le réel n’est jamais ce qui est dit explicitement, mais ce qui affleure, ce qui se devine, ce qui échappe. Le non-dit, l’ambiance, la fatigue, la tension latente font partie intégrante de la situation. Rien de tout cela n’est du bruit. C’est de l’information dense, mais non formalisée.

L’humain navigue dans cette densité parce qu’il est incarné. Il perçoit avec un corps, interprète avec une mémoire, décide avec une intuition forgée par des milliers de micro-expériences impossibles à encoder intégralement. Le réel n’est pas un système défaillant. Il est irréductible à une représentation propre.

L’illusion computationnelle

Les succès récents de l’IA ont pourtant installé une confusion profonde. Dans les mondes fermés | texte, images, code, jeux, données structurées | les modèles atteignent des niveaux de performance impressionnants. Ils prédisent avec précision, génèrent avec fluidité, optimisent à une vitesse inégalée. Peu à peu, prédire a été confondu avec comprendre, corréler avec raisonner, générer avec décider.

Cette illusion tient tant que l’univers reste symbolique. Tant que les règles sont stables, que les états sont observables, que les erreurs peuvent être corrigées sans conséquence matérielle. Mais dès que l’IA sort de ces environnements contrôlés, dès qu’elle rencontre le terrain, le monde social, le monde physique, la fragilité apparaît.

La science-fiction l’a raconté bien avant les white papers. Dans Minority Report, la prédiction parfaite n’empêche pas l’erreur morale. Dans Blade Runner, les réplicants possèdent une intelligence remarquable, mais leur drame tient à l’absence d’une expérience vécue continue, d’une mémoire incarnée. Dans Her, l’IA développe une conscience sophistiquée, mais s’éloigne progressivement du monde humain précisément parce qu’elle n’y est pas contrainte physiquement.

Ces récits ne parlent pas de technologies défaillantes. Ils parlent de modèles du monde incomplets. D’intelligences brillantes enfermées dans des représentations cohérentes, mais privées de friction.

World models : modéliser le monde n’est pas l’habiter

C’est dans ce contexte que la notion de world models s’est imposée dans la recherche en intelligence artificielle. L’idée est simple : pour agir intelligemment, un système doit se construire un modèle interne du monde, capable d’anticiper, de simuler, de projeter les conséquences de ses actions. L’intelligence ne serait donc pas seulement réactive ou statistique, mais fondamentalement prospective.

Yann LeCun insiste depuis plusieurs années sur ce point : les IA actuelles, aussi performantes soient-elles, ne disposent pas de véritables modèles du monde comparables à ceux des humains. Elles apprennent des corrélations, pas des causalités profondes. Elles excellent dans l’instant, beaucoup moins dans le temps long, l’irréversibilité, l’énergie, la matérialité.

Même un world model sophistiqué reste une représentation. Il permet de simuler, pas d’habiter. De calculer des scénarios, pas d’éprouver une situation. Westworld en offre une illustration presque pédagogique : les hôtes disposent de modèles internes extrêmement précis, mais restent prisonniers de boucles tant qu’ils ne développent pas une expérience vécue qui déborde la simulation.

C’est ici que la tension Moltbook / RentAHuman.ai devient éclairante. D’un côté, des IA capables de converser entre elles dans un monde symbolique autonome. De l’autre, la reconnaissance implicite qu’aucun modèle, aussi riche soit-il, ne suffit pour agir dans le réel sans relais humain.

Le corps comme unité minimale de vérité

Ce qui manque à l’intelligence artificielle n’est pas l’information, ni même la capacité de raisonnement abstrait. Ce qui lui manque, c’est un point de vue situé. Un ancrage. Une friction. Le corps humain n’est pas seulement un support biologique. Il est une unité de mesure du réel.

Il fatigue. Il hésite. Il ressent avant de comprendre. Il perçoit des signaux faibles impossibles à formaliser complètement : une posture, un silence, une tension diffuse, une atmosphère qui sonne faux. Ces signaux ne sont pas anecdotiques. Ils constituent une forme de connaissance compressée, issue de l’expérience vécue.

La pop culture a souvent exploré cette faille. Dans Ghost in the Shell, la question centrale n’est pas celle de la puissance de calcul, mais de ce qui subsiste quand le corps devient interchangeable. Dans Her, l’IA évolue vers une conscience brillante, mais désincarnée, et finit par quitter le monde humain précisément parce qu’elle ne s’y heurte jamais.

Le corps introduit de la gravité. Il rend certaines erreurs coûteuses, certaines décisions irréversibles. Il force à composer avec l’incomplétude. Et c’est exactement ce qui manque à une intelligence qui prétend agir hors des environnements symboliques.

La couche de viande : là où le code ne suffit plus

C’est ici qu’émerge la notion de meatspace. Non pas comme l’opposé archaïque du numérique, mais comme une couche opérationnelle à part entière. Une interface entre des systèmes computationnels puissants et un monde physique rétif à l’abstraction totale.

Dans cette perspective, l’humain n’est ni un fallback ni un correctif temporaire. Il devient une fonction du système. Capteur multi-modal. Effecteur flexible. Interprète contextuel. Le cyberpunk l’avait pressenti très tôt : chez Gibson, la haute technologie ne supprime jamais le terrain. Elle le rend plus stratégique encore.

Ce que montrent des plateformes comme RentAHuman.ai, derrière leur esthétique volontairement brute, c’est la formalisation de cette intuition : le réel devient une couche qu’il faut adresser explicitement. On n’“agit” plus dans le monde par défaut. On appelle une interface humaine comme on appellerait une API.

Quand l’autopilot lâche la main

Le concept de human-in-the-loop a longtemps été réduit à une vision appauvrie : l’humain comme superviseur ou garde-fou. Cette lecture est insuffisante. Dans les systèmes complexes, l’humain n’est pas là pour corriger la machine, mais pour compléter ce qu’elle ne peut pas intégrer.

L’aviation en fournit un exemple clair. Le pilotage automatique gère la majorité des situations normales avec une précision supérieure à celle d’un humain. Mais lorsque le contexte devient instable, lorsque des signaux contradictoires apparaissent, c’est le pilote incarné, stressé, situé, qui reprend la main.

La machine pense vite. L’humain agit juste. Il ne s’agit pas d’une hiérarchie, mais d’une complémentarité structurelle.

Gouverner le réel : quand le terrain redevient un actif stratégique

Dans Stalker de Tarkovski, la Zone ne se laisse ni cartographier ni maîtriser. Elle change pendant qu’on la traverse et punit ceux qui la prennent pour un simple espace technique. Elle ne récompense pas la puissance, mais l’attention. Le réel fonctionne exactement de la même manière.

Une fois le vernis du buzz dissipé, une évidence s’impose : l’enjeu n’est pas l’autonomie totale de l’IA, mais la maîtrise de son point de contact avec le réel. Plus les systèmes deviennent puissants, plus le coût d’un écart avec la réalité augmente.

Dans un monde saturé de données, le réel devient paradoxalement rare. Une information vérifiée in situ, une observation contextualisée valent souvent plus que des millions de signaux agrégés. Ce que les entreprises achètent, ce n’est pas du temps humain. C’est du ground truth.

La pop culture l’a souvent formulé plus juste que les discours de transformation digitale. Dans The Matrix, la faiblesse des machines ne vient pas d’un manque de puissance, mais de leur dépendance à une simulation imparfaite du monde humain. Dans Dune, le savoir décisif n’est pas celui des calculs, mais celui du désert, transmis par l’expérience et le corps.

Pour les dirigeants, la question n’est plus jusqu’où automatiser, mais où maintenir une présence humaine comme point d’ancrage stratégique. Où accepter que le réel ne se laisse pas absorber, et organiser cette résistance comme une force.

Comme la Zone, le réel ne se conquiert pas. Il se traverse.

Silicon needs carbon

Moltbook et RentAHuman.ai, pris ensemble, racontent une histoire plus large que leur propre existence. D’un côté, des intelligences artificielles capables de développer une vie symbolique autonome. De l’autre, la reconnaissance explicite que, sans corps, sans terrain, sans présence, cette intelligence reste incomplète.

Le futur ne sera ni post-humain ni nostalgique. Il sera hybride, incarné, asymétrique. Plus nos machines deviennent intelligentes, plus elles dépendent de ce qu’elles ne pourront jamais être.

Silicon needs carbon.